在当今数据驱动的时代,高效、可靠的存储与检索技术是数据处理服务的基石。日志结构合并树(Log-Structured Merge-Tree,简称LSM树)作为一种经典的存储引擎设计,因其出色的写入性能和高吞吐量,被广泛应用于NoSQL数据库(如LevelDB、RocksDB、Cassandra)和大数据系统中。本文将通过一个LSM树的实现案例,深入剖析其核心原理,并探讨其在现代数据处理与存储服务中的应用架构。

一、LSM树核心原理回顾

LSM树的核心思想是将随机写入转换为顺序写入,从而充分利用磁盘顺序I/O的高性能。其基本结构通常包含两部分:

- 内存组件(MemTable):一个驻留在内存中的有序数据结构(如跳表、AVL树或红黑树),用于接收所有新的写入和更新操作。当MemTable达到一定大小阈值后,它会被标记为不可变的(Immutable MemTable),并准备刷写到磁盘。

- 磁盘组件(SSTable - Sorted String Table):不可变的MemTable被顺序写入磁盘,形成一个个按Key排序的、不可变的数据文件,即SSTable文件。这些SSTable文件被组织成多层(Level),通常越往下的层级,包含的数据范围越广,文件也越大。

LSM树通过后台的“合并”(Compaction)进程,将多个小的、可能存在重叠Key范围的SSTable文件合并成更大、更有序的新文件,并清理已删除或过时的数据,从而控制读放大和空间放大问题。

二、一个简化的LSM树实现案例

假设我们正在构建一个轻量级的键值存储引擎。以下是其核心模块的简化实现思路:

1. 内存表(MemTable)实现

- 使用并发跳表(Concurrent SkipList)作为内存数据结构,支持高并发插入与查找。

- 每个写入操作(Put/Delete)都被追加到一个预写日志(Write-Ahead Log, WAL)中以确保持久性,然后插入MemTable。

- 当MemTable大小超过预设值(如64MB),将其状态转为只读,并创建一个新的活跃MemTable接收后续写入。旧的MemTable则被调度进行刷盘。

2. SSTable文件格式与刷盘

- 不可变MemTable被遍历,生成按Key排序的数据块序列。

- 每个SSTable文件包含:数据块区、元数据索引区(记录每个数据块的起始Key和文件偏移)、布隆过滤器(Bloom Filter)和文件尾部元数据(如版本、压缩类型)。

- 刷盘过程是顺序I/O,速度极快。刷盘完成后,对应的WAL日志可以被安全删除。

3. 多级存储与合并策略

- 我们采用类似LevelDB的分层策略。Level 0(L0)存放直接从MemTable刷新的SSTable,允许文件间Key范围重叠。

- Level 1及以上(L1, L2...)的每个层级有明确的大小限制,且同一层内的SSTable文件必须保证Key范围不重叠。

- 当某一层的数据量超过阈值时,触发合并操作。例如,从L0中选择一个文件,与L1中Key范围有重叠的所有文件进行多路归并排序,生成新的SSTable文件写入L1。L1到L2的合并同理。这种策略在写入放大、读放大和空间放大之间取得平衡。

4. 读取流程

- 读取一个Key时,首先查询活跃的MemTable。

- 若未找到,则依次查询不可变MemTable。

- 若仍未命中,则从磁盘层级中查找。利用每个SSTable附带的布隆过滤器可以快速跳过不可能包含该Key的文件。从L0开始,由于L0文件有重叠,可能需要查询多个文件;对于更高层级,由于Key范围不重叠,通常每个层级最多只需查询一个文件。

- 找到Key对应的最新版本数据后返回(删除标记则返回“未找到”)。

三、集成于数据处理与存储服务

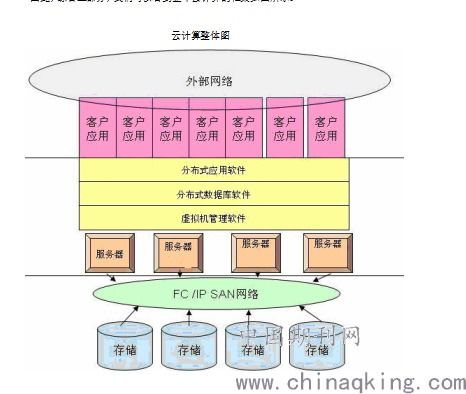

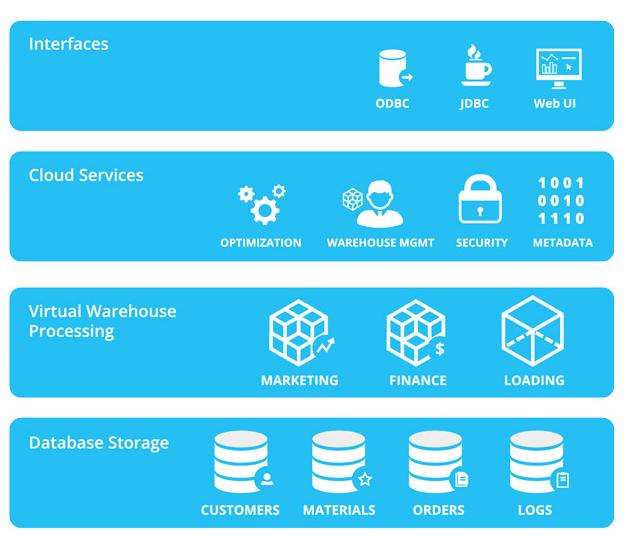

将上述LSM树引擎作为核心存储层,我们可以构建一个完整的数据处理与存储服务。该服务架构可能包含以下组件:

- API服务层:提供RESTful或gRPC接口,接收客户端的PUT、GET、DELETE、SCAN等操作请求。

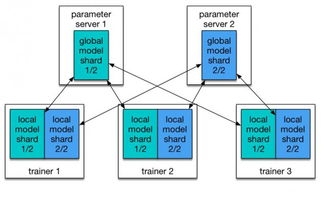

- 请求处理与路由层:对于分布式部署,此层负责根据Key进行分片路由,将请求转发到正确的存储节点。

- 核心存储引擎(LSM树实例):每个存储节点运行一个或多个LSM树实例,管理本节点的数据。可以配置不同的合并策略、压缩算法(如Snappy、Zstd)以适应不同工作负载(写密集、读密集或混合)。

- 高可用与复制:通过主从复制(如Raft、Paxos共识算法)或多副本机制,将数据同步到多个节点,确保服务可用性与数据持久性。WAL日志在复制中扮演关键角色。

- 后台服务:

- 合并调度器:持续监控各级别SSTable数量与大小,智能调度合并任务,避免影响前台I/O。

- 快照与备份:定期创建SSTable文件的快照,并备份到对象存储(如S3)以实现灾难恢复。

- 监控与调优:收集性能指标(如写入延迟、读取延迟、合并I/O量),为动态调整参数(如MemTable大小、合并触发阈值)提供依据。

四、优势与挑战

优势:

- 极高的写入吞吐量:得益于顺序写入和批量刷盘。

- 良好的空间局部性:SSTable文件有序且压缩,节省存储空间。

- 适应海量数据:层级结构便于管理远超内存容量的数据集。

挑战与优化方向:

- 读放大:一次查询可能涉及多个SSTable文件。优化手段包括精心设计合并策略、使用布隆过滤器、引入块缓存(Block Cache)和行缓存(Row Cache)。

- 写放大:合并过程可能重写大量数据。采用分层大小比例调优、选择更智能的合并算法(如RocksDB的通用合并)可以缓解。

- 空间放大:旧版本数据在被合并清理前会暂时占用空间。通过调整数据保留策略和控制合并频率来管理。

结论

LSM树通过其独特的设计,在牺牲部分读取性能的前提下,换来了卓越的写入性能,非常适合写多读少、数据量持续增长的应用场景。从LevelDB到RocksDB,工业界的持续优化证明了其强大的生命力。理解并实现一个LSM树案例,是深入掌握现代数据库存储内核的关键一步。将其融入一个完整的数据处理与存储服务架构中,则需要综合考虑分布式、一致性、高可用等系统工程问题,从而构建出稳定、高效、可扩展的数据基础设施。